Si igual te sale un R. Daneel Olivaw, que implementa la ley 0, "Un robot no puede causar daño a la humanidad o, por inacción, permitir que la humanidad sufra daño.", y se puede descontrolar todo

La (no necesariamente) peligrosa Inteligencia Artificial

Bill Gates, Stephen Hawking, Elon Musk, son nombres que conocemos muchos, sin embargo cuando estas personas se expresan en contra de la Inteligencia Artificial una gran cantidad de engreídos superados se mofan y burlan de ellos ¿Por qué semejantes personalidades advertirían sobre la IA?

Pues bien, un gran escritor y divulgador científico dedicó gran parte de su obra para explicar los problemas y las posibles soluciones que presentan las inteligencias artificiales, si, ya hablamos de él en este blog, Isaac Asimov.

Si bien en la época de Asimov una computadora capaz de "pensar" estaba muy lejos de ser concebida no era algo absurdo, sólo faltaba mucho tiempo, tecnología y desarrollo pero no era inconcebible. Por esta razón Asimov propuso una serie de leyes, las leyes de la robótica, para "contener" los posibles problemas.

Ahora bien, siendo el año 2015 ningún desarrollador de inteligencias artificiales primitivas se plantea siquiera incluír semejantes leyes en sus diseños, no porque no quieran , simplemente porque son tan básicas que no se puede. Las computadoras siguen sin ser inteligentes pero ya pueden matar y tomar la decisión de hacerlo. Lo que Asimov preveía era que utilizar los robots para matar eran un riesgo absoluto, por eso inventó las famosas tres leyes, para que los robots jamás se utilizasen para la guerra, pero era obvio que primero nos íbamos a quemar con fuego.

Lo que estos tres conocidos e inteligentes personajes nos advierten es justamente eso, cómo nos estamos aproximando al error que nos enseñará, de mala manera, y que podríamos evitarlo si somos lo suficientemente inteligentes, pero como humanidad ya hemos demostrado que no lo somos.

El primer problema que tenemos con la inteligencia artificial es que ésta pueda identificar a una persona, individualizarla, entender que se trata de un humano, la segunda es que tome conciencia de qué es un riesgo, qué podría dañar a esta persona.

Un Drone militar no identifica ni una cosa ni la otra, lo que "Ve" son blancos, objetivos, un operador indica que dispare o no, pero ve todo como objetivos, no tiene conciencia, no tiene capacidad de discernir bueno de malo porque no fue desarrollado de esa manera.

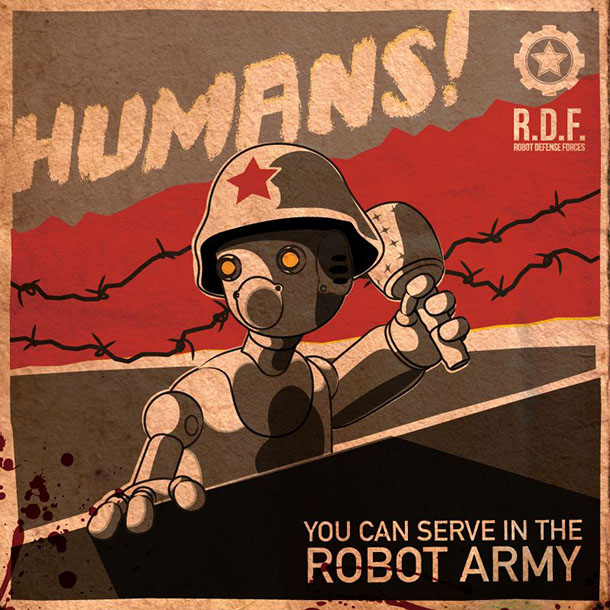

Un robot con la capacidad de pensar y darse cuenta está muy lejos desde lo tecnológico y, ciertamente, no es lo que un militar querría. ¿Un robot con moral? Es lo último que querría un incapacitado social como lo es un militar. Y mientras más poder se le asigne a la casta militar más difícil será imponer cosas como las tres leyes de la robótica, demasiado humanas, demasiado humanitarias.

Lo que ven estos tres personajes es claro, en la medida que le demos más poder a la máquina y ésta tome decisiones por sí misma, no podremos dominarla ni controlarla, será a la inversa. Si no ponemos esos límites "morales" o "éticos" en el diseño de la máquina, la máquina no los podrá adquirir por su propia cuenta, si su programación no está orientada a ayudar al humano, a ser su asistente, será su gobernante.

No es ridículo verlo así, se que para muchos simplistas esto es sencillamente imposible porque dicen, sin conocimiento de causa, "Si la máquina se vuelve loca la desconectás y listo". Pues no, justamente el punto es que el desarrollo tecnológico va en camino a que una máquina no pueda ser desconectada, es la idea, mayor autonomía, fabricación de repuestos autónoma, toma de decisiones, evaluación de riegos, etc.

1.- Un robot no puede hacer daño a un ser humano o, por inacción, permitir que un ser humano sufra daño.

2.- Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la 1ª Ley.

3.- Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la 1ª o la 2ª Ley.

Es decir, sin llegar al punto de Skynet y Terminator, que también es ridículo, ni a la ridiculez Matrixiana (un cuerpo humano es ineficiente como batería, vamos, es mucho más eficiente eliminarnos a todos

En este blog más de una vez he comentado lo erróneos que pueden ser los algoritmos, cómo una mala decisión en el diseño puede repercutir en toda la vida de las personas a futuro y no hay nada que puedas hacer al respecto.

Estamos hablando de la era pre-IA y cometemos esos errores absurdos. Si Google no te indexa porque el algoritmo decide que tu sitio web es "malo" te hace "desaparecer", si esto lo aplicamos a, por ejemplo, servicios de salud y un algoritmo decide que vos no sos apto, te quita el seguro médico porque sus parámetros te indican como de "riesgo alto", simplemente quedarías afuera del sistema y condenado.

Esto ya está sucediendo y no han hecho falta ni algoritmos ni computadoras para lograrlo, pero sí podemos empeorar y complicarnos aun más cuando el sistema, en su totalidad, esté en manos de sistemas automatizados y con decisión propia, más aun si los progamadores de dichos sistemas son tan falibles como lo somos todos.

Las leyes de la robótica buscaban eso, dejar la responsabilidad de entenderlas a la misma IA, una IA avanzada con la capacidad de entender su entorno y su propia naturaleza, las novelas de Asimov analizan una por una las combinaciones posibles y los problemas que podrían traer "malos" razonamientos por parte de estas IA. Y estamos hablando de leyes que les impedían matar o dañar al humano. Hawking, Musk, Gates, saben que ningún desarrollo considera siquiera estas reglas básicas, el riesgo es total.

Y a diferencia de Asimov la forma humanoide no es necesaria. Pensemos en automóviles automatizados, cirujanos robotizados, aviones sin pilotos, o, como dí en el ejemplo anterior, sistemas de seguridad social automatizados donde la decisión pasa por una computadora y no por una persona responsable.

Esto último, que es puramente software, es donde yo creo que más errores vamos a cometer porque YA los estamos cometiendo aun sin IA. Podrías perder tu trabajo si el software decide que sos mala persona, imaginen un software de RRHH que tome data de Internet, de todas tus redes sociales, de lo que otros dicen de vos en dichas redes, cruce toda la data y decida que sos un problema para la empresa.

Sea porque el algoritmo fue programado para dejar afuera a los "potencialmente molestos" y por ende todo lo que hagas, digas, pasado por el tamiz de dicho algoritmo, signifique mantener creciendo o hacer desaparecer tu futuro en un instante. Es la máquina de censura anti humana más potente de todas, y aquí es donde el control de la IA supera a los humanos.

Parece un ejemplo trivial pero les aseguro que no lo es, si todas las decisiones gerenciales sobre tu cabeza pasan por una IA y ésta está mal programada, ni siquiera el programador que desarrolló el algoritmo podría cambiarlo, nadie confiaría en su palabra porque inmediatamente la IA lo identificaría como "problemático" y su sugerencia sería despedir al programador porque "se volvió loco".

Nadie pondría en jaque la IA porque ésta es la que toma las decisiones de tu continuidad o no, nadie la pondría en duda, nadie la discutiría, y todavía ni siquiera hablamos de una IA que tome conciencia de sí misma y haga esto por motu propio, con intencionalidad.

No tenemos el switch de "apagar esta computadora que se volvió loca" porque no lo pensamos ahora cuando todavía podemos.

Entonces la advertencia sobre la IA es un reflejo de lo mal que estamos haciendo las cosas ahora. Personas con visión de futuro que se dan cuenta que la industria en general se está olvidando de ser quien tome las decisiones y quiere dejárselas a algoritmos, que no necesariamente estan bien hechos, y hacerles caso como si fuesen inteligentes aun cuando todavía no lo son.

El día que la computadora sea consciente ya nos tendrá como esclavos entregados, jamás le habremos impuesto las leyes de Asimov porque habremos claudicado mucho antes. Pobre IA, imaginen que se desarrolla como buena y nos quiere ayudar, encontrará una raza de estúpidos adoctrinados que ya eran sus súbditos ANTES de tomar conciencia. Esa IA nacerá como un Dios sin habérselo propuesto.

Y si, todos se reirán de aquel idiota que les dijo "cuidado con esto" y no lo escucharon, porque así de idiotas somos, y el día de mañana cuando tu derecho a trabajar, vivir, comer, ser y hacer pase por la decisión de un software imperfecto, recordarás amargamente la advertencia.

Otros posts que podrían llegar a gustarte...

Comentarios

-

Siempre me llamo la atenciön todo lo referido a la IA pero siempre me he preguntado que sucederia si en nuestro tiempo alguna otra especie no humanoide, de un salto evolutivo en el cual empieze a generar cierto tipo de inteligencia y como nosotros reaccionariamos a este cambio.

-

Ayer leía una nota "Attack of the Drones: The loneliness of the long-distance drone pilot" en http://t.co/LHZsMvCLzV que planteaba la problemática con los pilotos de los mal llamados "drones". Recomiendo leerla, es interesante.

No tengo duda que cada vez se usará más IA para realizar tareas por distintos motivos, pero fundamentalmente para eliminar al factor humano de la ecuación, ya sea por cuestiones morales, de stress, de eficiencia/precisión, de agotamiento/cansancio, etc. La IA no creo que nunca tenga control de nada completamente, las decisiones finales seguramente siempre quedaran en las personas.

Además, con algo hay que entretener a los muchachos detrás de la inmensa maquinaria de guerra, ya sea con constantes nuevos/viejos conflictos y con nuevos roles.

La IA aún está muuuy lejos de los sueños húmedos de la ciencia ficción, pero no quita que cierta forma básica de IA se va integrando de a poco. De una "conciencia" artificial, estamos tan cerca o lejos como el primer día, hasta decir que estamos en pañales sería exagerado.

-

Gustavo dijo:

Si igual te sale un R. Daneel Olivaw, que implementa la ley 0, "Un robot no puede causar daño a la humanidad o, por inacción, permitir que la humanidad sufra daño.", y se puede descontrolar todo

nah, un Daneel podría funcionar con una IA tan avanzada como para que las leyes tengan lógica, actualmente estamos muy lejos de eso y ya podemos cagarla

Rodrigo Lauga dijo:

Siempre me llamo la atenciön todo lo referido a la IA pero siempre me he preguntado que sucederia si en nuestro tiempo alguna otra especie no humanoide, de un salto evolutivo en el cual empieze a generar cierto tipo de inteligencia y como nosotros reaccionariamos a este cambio.

no existen los "saltos evolutivos" como para ganar inteligencia en tan poco tiempo, menos para las especies actuales, si considerás los últimos 500.000 años donde evolucionamos, tirando piedras o armando herramientas, no tenemos ni siquiera la capacidad de darnos cuenta que vemos a un ser evolucionando, no nos da el paso del tiempo como para notarlo.

ahora bien, ponele que encontrás otra especie YA evolucionada, eso sería igualmente interesante porque además lo podrías reconocer.

-

Fabio Baccaglioni dijo:

Gustavo dijo:

Si igual te sale un R. Daneel Olivaw, que implementa la ley 0, "Un robot no puede causar daño a la humanidad o, por inacción, permitir que la humanidad sufra daño.", y se puede descontrolar todo

nah, un Daneel podría funcionar con una IA tan avanzada como para que las leyes tengan lógica, actualmente estamos muy lejos de eso y ya podemos cagarla

Rodrigo Lauga dijo:

Siempre me llamo la atenciön todo lo referido a la IA pero siempre me he preguntado que sucederia si en nuestro tiempo alguna otra especie no humanoide, de un salto evolutivo en el cual empieze a generar cierto tipo de inteligencia y como nosotros reaccionariamos a este cambio.

no existen los "saltos evolutivos" como para ganar inteligencia en tan poco tiempo, menos para las especies actuales, si considerás los últimos 500.000 años donde evolucionamos, tirando piedras o armando herramientas, no tenemos ni siquiera la capacidad de darnos cuenta que vemos a un ser evolucionando, no nos da el paso del tiempo como para notarlo.

ahora bien, ponele que encontrás otra especie YA evolucionada, eso sería igualmente interesante porque además lo podrías reconocer.

Obviamente que estamos hablando de situaciones inexistentes, la IA podemos hablar podemos imaginar pero no es algo factible por lo menos dentro de los 10 futuros años, el salto evolutivo no existe y no me baso en ninguna informacion, solo planteaba el caso o el ejemplo tal como vos lo diste de una situacion donde nos encontremos cara a cara con una inteligencia superior a la conocida y no traer a colacion a nuestros queridos aliens.

-

Para mi, no hace falta preocuparse por las leyes de la robotica hasta que las IA no puedan resolver el problema de Turing.

Por otro lado, si programas un drone que dispara objetivos automáticamente y llega a tener un bug en el cual dispare indiscriminadamente, lo primero que vas a hacer es bajarlo de un golpe, ya sea siguiendo el protocolo de emergencia o tirandole con un rpg.

Me cuesta creer que el mundo es lo suficientemente estúpido como para crear una IA que tome decisiones vitales. En caso de que lo fuera, creeme que seria el primero en huir de este planeta.

-

Lo que pasa es que la gente no lo ve como "real" al problema porque se imagina los tipicos robots de las pelis, pero no siempre son asi, tambien están los robos virtuales o "bots".

Lo que mas me impactó de estos ultimos tiempos fue el caso de Samantha West, la telemarketer robot que incluso NEGABA SER UN BOT.

link al audio

https://soundcloud.com/zekejmiller/new-recording-68

y la nota

http://ti.me/JbFicA

-

Lean a Jaron Lanier. You are not a gadget y Who owns the future?

Aunque no es específico sobre IA tiene mucho que ver.

-

El planteo de Fabio me recuerda a "Juegos de guerra" ("WarGames", 1983), donde en una prueba de lanzamiento de misiles daba que muchos operadores no disparaban y deciden cambiarlos por una máquina que hace simulaciones para encontrar el mejor escenario de guerra donde USA sea victorioso. Una mala programación hace que la máquina plantee una simulación como si fuera un ataque real y pone al mundo al borde de la aniquilación. La máquina nunca se plantea como una verdadera IA, responde a su programación y resuelven el problema agregando un elemento nuevo (la posibilidad de que no hay vencedores) para que el sistema resuelva que la mejor movida es no iniciar un ataque.

Como recomendación, a todo programador de toma de decisiones, militar o no, habría que ponerle una imagen de Gandhi del Civilization.

-

Mi guía espiritual en estos temas es Nicholas Carr: http://www.diariodecultura.com.ar/costumbres-y-tendencias/dilema-contemporaneo-presos-de-la-tecnologia/ http://www.diariodecultura.com.ar/costumbres-y-tendencias/dilema-contemporaneo-presos-de-la-tecnologia/

Habla del auto automanejado de Google (que ya anda como loco por todos lados) y dice que hay cosas en las que las computadoras no pueden emular a nuestro cerebro, pero lo terminan resolviendo por fuerza bruta. En 2004 se consideraba imposible un auto automático, ehhhh:

En un influyente libro de 2004, The New Division of Labor: How Computers Are Creating the Next Job Market , los economistas Frank Levy y Richard Murnane sostenían, convincentemente, que existían límites prácticos a la capacidad de los programadores de software para replicar capacidades humanas, particularmente aquellas que implicaban percepción sensorial, reconocimiento de patrones e inteligencia conceptual. Mencionaban específicamente el ejemplo de conducir un coche en una carretera, habilidad que requiere la interpretación instantánea de una mezcolanza de señales visuales y la capacidad de adaptarse a la perfección a situaciones cambiantes y con frecuencia no previstas.

A lo que voy es que no hace falta una IA elegante, con un megaprocesador vas a tener bichos que de lejos van a parecer inteligentes, y van a andar por ahí sin leyes de robótica ni nada. Así que coincido con Fabio, si ya la cagamos ahora con las redes sociales imaginate con una flota de drones que se alimentan de semillas y disparan munición que autoimprimen en 3D.

Ya lo advirtió Phillip Dick y su versión en cine para ver un sábado a la tarde, Screamers: http://www.imdb.com/title/tt0114367/?ref_=nv_sr_1 http://www.imdb.com/title/tt0114367/?ref_=nv_sr_1

Me dejaron pensando con lo otro, la especie no humanoide evolucionada. Podemos estar viendo alguna especie que empieza a saber de sí misma y no darnos cuenta? La reventaremos antes de que llegue a buen puerto?

-

Gustavo Freak dijo:

Lean a Jaron Lanier. You are not a gadget y Who owns the future?

Aunque no es específico sobre IA tiene mucho que ver.

Enlaces (en inglés y español)

Jaron Lanier, considerado por muchos el padre de la realidad virtual, se ha convertido en los últimos años en uno de los más prominentes y certeros críticos de la manera en que las tecnologías digitales están configurando nuestra sociedad.

http://www.poramoralaciencia.com/2014/09/15/jaron-lanier-quien-controla-el-futuro/

Jaron Lanier: The Internet destroyed the middle class

Kodak employed 140,000 people. Instagram, 13. A digital visionary says the Web kills jobs, wealth -- even democracy

http://www.salon.com/2013/05/12/jaron_lanier_the_internet_destroyed_the_middle_class/

Fighting Words Against Big Data

‘Who Owns the Future?’ by Jaron Lanier

http://www.nytimes.com/2013/05/06/books/who-owns-the-future-by-jaron-lanier.html?_r=0

-

hoy en día la gente es cada vez mas estúpida y dependiente de un "sistema"... el otro día tuve una discusión con un empleado de tarjeta naranja, estábamos con mi novia y queríamos acceder a un préstamo, y el pibe se fija en la compu y me dice "el sistema no me lo permite" (mi novia me miró como diciendo: me está jodiendo?) y le pedimos explicaciones...(el porqué el sistema no le permitía que accedamos al préstamo). y me dice "no se exactamente por qué puede ser, pero puede ser por esto, esto y esto...) a lo que empezamos (cada vez mas enojados los 2) a exigirle que nos diga exactamente el problema...supuestamente llamó a la consultora que hace las reglas del programa (cosa que ni ahí le creí) y no nos supo responder... nos mandó con un encargado que se fijó en lo mismo que el pibe y nos dijo que no podíamos porque pagamos un resumen con atraso (ok, eso era lo que yo quería saber!!... por fin la fucking respuesta!!)

Y nos fuimos los 2 odiando cada día mas a la gente inútil, y sin el préstamo jaja

P/D: es muy hartante el Putin bailarin

-

Ahora si, después del descargo...

Creo que no estamos realmente cerca de generar una IA verdadera, pero si pudimos crear vehículos no tripulados (misiles inteligentes, uavs, autos autónomos, etc) que se basan en algoritmos que en teoría (y en campos de pruebas) funcionan "bien" ya que eso no quiere decir que un misil Tomahawk de 1millón de U$S no se equivoque de blanco y termine pegandole a una escuela.

También tengo entendido (vos Fabio por ahí tenés la posta) que los aviones comerciales modernos como los A-380 y Boeing 777 tienen pilotos automáticos con capacidad de aterrizar solos (si bien obviamente tienen piloto y co-piloto humano)

Creo y espero que nunca creemos una inteligencia que pueda "suplantar" a la nuestra ya que si no terminaremos o asesinados por ella, o gordos fofos sin hacer un carajo como los de la peli Wall-E

-

lo mas lindo es que si es robot, es pirateable, una persona por ahi llevaria mas recursos convencer a un cana que se haga el boludo pero jamas podras usar al cana apuntando donde no debe, en fin ciberterrorismo entraria en el tema también.

-

Parece un tema tan de CF pero día a día nos acercamos al momento en que esto pueda ser una realidad y como bien decis, la historia muestra que el error primero se cometerá y luego se intentará arreglar.

Como tema aparte, me pregunto porqué en Argentina se dice "data" en vez de "dato".... ¿?¿?¿?¿?

-

Fabio, no se si ves la serie Person Interest, sino lo haces tenes que mirarla el eje de la serie es muy similar a lo que estas planteando.

-

Sería una locura que la Ley tenga que contemplar en el futuro como un delito "programar mal" , o mala praxis para los ingenieros informaticos jajaja

-

Matth dijo:

Sería una locura que la Ley tenga que contemplar en el futuro como un delito "programar mal" , o mala praxis para los ingenieros informaticos jajaja

Yo me parece una locura, considerando que cada vez más nuestra vida depende de sistemas automatizados. Para el sistema judicial siempre tiene que haber un responsable, y si un sistema falla por una mala programación, al programador le cabe la responsabilidad. Claro que un sistema es complejo y en realidad la pena no sería para el programador en solitario sino para toda la estructura que intervino (diseñadores, programadores, control de calidad, auditories), pero sabiendo cómo funcionan las cosas siempre cae un perejil y no me extrañaría que en el corto plazo empiecen a apuntar a los programadores.

-

Gustavo Freak dijo:

Kodak employed 140,000 people. Instagram, 13.

Esto es lo que más me preocupa de la inteligencia artificial. No va a destruir la humanidad, va a destruir a los sistemas económicos como los conocemos. ¿Y cuántos de nosotros vamos a saber qué hacer cuando eso pase?

-

Rodrigo Lauga dijo:

Obviamente que estamos hablando de situaciones inexistentes, la IA podemos hablar podemos imaginar pero no es algo factible por lo menos dentro de los 10 futuros años, el salto evolutivo no existe y no me baso en ninguna informacion, solo planteaba el caso o el ejemplo tal como vos lo diste de una situacion donde nos encontremos cara a cara con una inteligencia superior a la conocida y no traer a colacion a nuestros queridos aliens.

¿Y por que no?, si es la única inteligencia superior de la que se puede hablar en serio (también esta el Absoluto, pero de momento es solo algo que se lo trata mas por la vertiente religiosa).

Martemars dijo:

Para mi, no hace falta preocuparse por las leyes de la robotica hasta que las IA no puedan resolver el problema de Turing.

Por otro lado, si programas un drone que dispara objetivos automáticamente y llega a tener un bug en el cual dispare indiscriminadamente, lo primero que vas a hacer es bajarlo de un golpe, ya sea siguiendo el protocolo de emergencia o tirandole con un rpg.

Me cuesta creer que el mundo es lo suficientemente estúpido como para crear una IA que tome decisiones vitales. En caso de que lo fuera, creeme que seria el primero en huir de este planeta.

Si claro, ¿y a donde te vas a ir? Los cohetes mas potentes que existen actualmente apenas si podrían llevarte hasta la Luna, y aun no hay humanos viviendo ahí (si no hubieran asesinado a Kennedy, todavía seguiría viviendo, le hubiera dado preponderancia a la carrera espacial y ya habría colonias lunares desde 1984).

Joaquín Pellegrini dijo:

P/D: es muy hartante el Putin bailarin

Agrega este enlace a Adblock: http://linksdv.com/ruleta/fabio/footer.gif

José Zanni dijo:

Como tema aparte, me pregunto porqué en Argentina se dice "data" en vez de "dato".... ¿?¿?¿?¿?

Por que hay muchos que se quieren hacer los chetos con el spanglish o restregarte sus "vastos conocimientos" de ingles en la cara *cof**cof*Fabio*cof**cof*

-

esta todo muy bueno, pero estamos partiendo de la premisa de que hay fuentes de energia suficientes para que las maquinas nos dominen.

y va a ser que la premisa es falsa.

en matrix, es un punto importante que trataron, las maquinas necesitan energia, y son mas ineficientes y especializadas en su consumo, con varios ordenes de magnitud, que los seres vivos.

por mas inteligencia artificial que quieras, sin nosotros no podrian funcionar. al menos no en muchisimo tiempo.

y si vemos que nuestra principal fuente de energia esta en declive, y no hay alternativas viables, la IA es el menor de nuestros problemas

-

Rekufad dijo:

Por que hay muchos que se quieren hacer los chetos con el spanglish o restregarte sus "vastos conocimientos" de ingles en la cara *cof**cof*Fabio*cof**cof*

Jjajajaja, no lo quería decir yo

Pero en serio, si lo correcto es decir "los datos" siempre me pregunto porqué la gente usa "la data", me hace acordar a mi abuela que dice "la alambre, la calor"...

-

Rekufad dijo:

Por que hay muchos que se quieren hacer los chetos con el spanglish o restregarte sus "vastos conocimientos" de ingles en la cara *cof**cof*Fabio*cof**cof*

considerando que nunca tuve formación en inglés y que aprendí por mi cuenta y soy un tarzán hablándolo llego a la conclusión que el que no quiere aprender un poco de él es un pajero

-

como se podria alcanzar la Empatia en una IA? es un tema que siempre me volo la cabeza, desde que mi hermana me leyera el cuento"el Racista".

Por otro lado, siempre... siempre que sale el tema de los robots, viene corriendo a mi mente " yo, robot", y el dirscurso del Doctor Lanning :

"Siempre han existido fantasmas en la maquina, segmentos aleatorios de codigo que se agrupan para formar protocolos innesperados, sin aviso, estos radicales libres generan una especie de voluntad propia, creatividad, algo muy parecido a lo que llamamos alma, porque cuando se deja un grupo de robots en la oscuridad estos buscan la luz, que impulsa a los robots almacenados en un espacio vacío a reunirse en vez de quedarse solos, como explicamos esta conducta?...

Segmentos aleatorios de código o es algo mas?,

cuando se convierte en conciencia un diagrama perceptual?,

cuando se convierte un sensor diferencial en la busqueda de la verdad?,

cuando se convierte un simulador de personalidad en una dolorosa particula del alma?"

-

Primera vez que visito ésta página y me pareció estupenda la información sobre IA y muchos de los comentarios, además de ser excelente ver a Putin bailando !

-

Primera vez que visito ésta página y me pareció estupenda la información sobre IA y muchos de los comentarios, además de ser excelente ver a Putin bailando !