Yo también veo varios niveles de responsabilidad acá. Como la IA es una herramienta genérica, no se puede atacar al creador de la IA (Open AI o quien sea). Sí es responsable de delito quien crea un sitio o herramienta derivada para crear pedofilia y/o nudificar menores y quien accede y crea contenido con estos.

En estos casos no se salva de ser "creación virtual". ¿De dónde salió el material para entrenar el modelo? Es como cierto periodista que defendió la pedofilia diciendo que solo tener fotos no lastimaba a nadie, pero no supo responder cuando le preguntaron cómo se obtienen las fotos.

La legislación debería ser más expeditiva, en especial porque es más fácil mejorar una ley que hacer un mamotreto de doscientos artículos que demanda meses (o años) en estudiar, debatir, modificar y, con suerte, aprobar. Las leyes deberían ser breves, simples y directas. Se que pensar como programador en un mundo de abogados es una utopía, pero nunca pierdo las esperanzas.

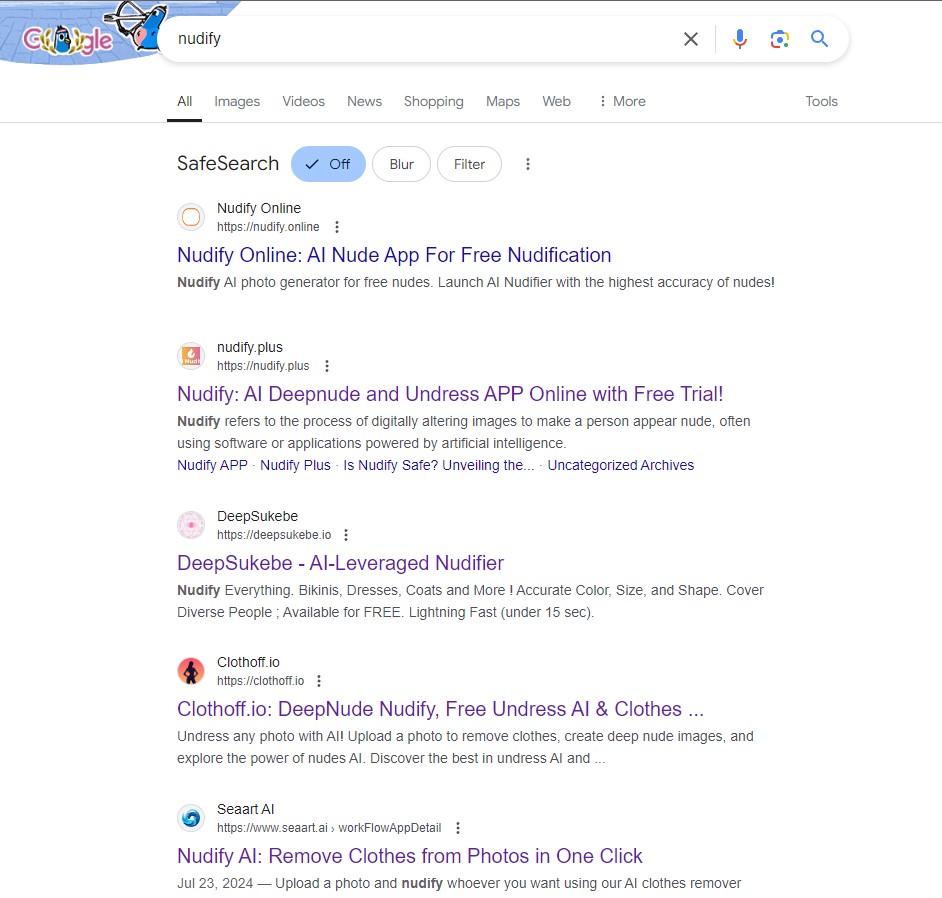

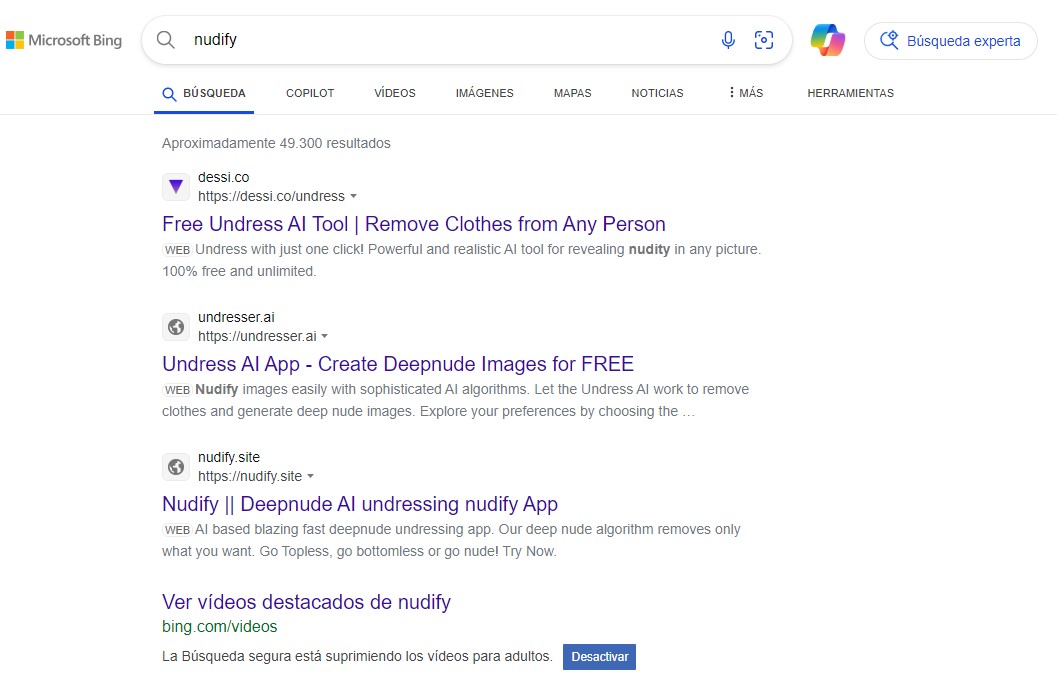

Nudify - Exponiendo inocentes (con Google promoviendo los sitios)

Una tendencia boluda de los últimos tiempos son los sitios para "desnudar" a gente, sin su consentimiento, con aplicaciones que usan alguna herramienta de AI sobre la imagen existente de alguien.

Son los famosos los que se quejan más de esto, pero no las principales víctimas, en cambio sucede más seguido con menores de edad, chicos y chicas en edad escolar, que son "humillados" por sus compañeros en una especie de bullying por AI.

¿Qué tan fácil es? Pues bien, basta con buscar en Google "Nudify" y van a ver los resultados de decenas de aplicaciones que Google ubica en los primeros resultados de búsqueda y que son (única y) exactamente para esto.

Hace unos días el fiscal de San Francisco estaba presentando una demanda para cerrar 16 de los sitios y aplicaciones más usados para "nudifear" fotos ya que la mayoría de las víctimas, niñas y jóvenes, estaban siendo atacadas en esos espacios.

Las apps están diseñadas específicamente para esto, tomar una fotografía y rellenar, donde haya ropa, con tetas y piel, desnudos totales, el contenido es obviamente AI pero el rostro y la foto original son de la víctima.

En varios estados de EEUU, así como en casi todos los países de la UE, generar una imagen falsa de alguien sin su consentimiento es ilegal, en el tercer mundo en el que vivimos todo esto es un viva la pepa, el tema es que por más ilegal que sea ¿Quién comete el delito? Es la parte que está en duda y en juego ahora, el desarrollo de ese juicio tendrá ramificaciones a futuro.

Como ya expliqué anteriormente, toda una gran división de la generación de imágenes por AI está dedicada a la pornografía, no tengo nada en contra de eso, cada uno hace lo que quiere con sus herramientas y sus fantasías, el problema está en que no hay nada discutido siquiera cuando se pasan ciertas barreras, la principal: cuando se invade a otra persona.

Un ejemplo es la generación y distribución de imagenes no consentidas, si se usa la identidad de una persona que no dio su aprobación, ya hay una violación de sus derechos (como mínimo), el segundo ejemplo más llamativo es la generación de pornografía infantil, tema que a todos les pone los pelos de punta, pero, será por el pudor que genera, ninguno se pone a discutir en detalle.

Justo con un caso llamativo en todos los medios sobre este mismo tema llama la atención la poca importancia que se le da a la discusión, es decir, el debate social. Es como que todos dan por entendido que eso ya está discutido y legislado, y no, a medias, pero tanto es el temor social por decir algo inadecuado que no se hace nada al respecto.

Tampoco hay nadie que pueda definir o dejar legalmente claro qué sucede con los que generan por AI pornografía infantil completa, pero sin niños. ¿Es pornografía? ¿Hay delito? Se resuelve con agregar un artículo a la ley actual, pero no veo que nada se mueva en ese sentido ¿Será porque más de un legislador es pedófilo? Al menos uno provincial cayó esta semana 🤷♂️

Como fuere, si no hay ley clara, los deepfakes van a seguir proliferando, lo que está prohibido en un país, pero permitido en otro, tiene mucha posibilidad de circulación legal. En un caso de EEUU fueron bien claros y arrestaron a uno bajo este criterio.

Desde ya que nada de esto tiene que ver con la herramienta de base, Stable Diffusion (o el modelo que estén usando), sino con quien entrena un modelo para obtener estos resultados en particular y crea una aplicación para tomar una imagen y reemplazar áreas específicas de una forma tan partiocular.

Usando esta idea, de que quien crea una herramienta así no es "responsable", aparecen miles de apps para "nudifear" (desnudar), pero aquí es donde yace la diferencia radical: estas herramientas SI están promovidas con ese fin, no es que uno está haciendo la chanchada con Photoshop, son herramientas específicas.

No es que "oh casualidad" los usuarios son unos pajeros terribles y la "mal usan", el fin específico y claro de la herramienta es desnudar gente, sin importar la edad ni el género, el consentimiento o no, es facturar dinero a cambio de morbo.

¿Son libres de hacerlas? Sí, no existe leglislación que las prohiba, así que es libertad de expresión y coso, aun así muchas cosas que hacemos, escribimos o grabamos son totalmente legales y Google (o Bing) se escudan en su precaria moralina para bajártelas, esto, en cambio, no.

Mientras discutimos si Twitter/X es una plataforma que tiene o no responsabilidad por lo que digan sus usuarios (como red social) tenemos al mismo tiempo otros que ni son considerados en discusión alguna y operan libremente y con total intencionalidad manifiesta, a esos no se los toca, no importan, no están a la vista así que no son parte de la agenda de nadie (y generan ingresos publicitarios!).

Otros posts que podrían llegar a gustarte...

Comentarios

-

en EEUU si no hay explotacion per-se no hay delito.

hay sitios que prohiben "imitaciones" o como quieran llamarlo.

igual en Reddit encontras un sub para todas las perversiones que busques y salvo que se hagan demasiado publicas (tipo jailbait) no los cierran, eso si para cerrar los subs de la derecha tipo el que daba soporte a Trump y de tematica men rights, eso si lo hacen en 30 segundos.

pero no podes esperar otra cosa de yanquis de California que son todo pro pedofilia y otras cosas asi contra los niños y niñas.

y despues de ver como hacen las leyes alla, estamos mas cerca que legalicen las relaciones con mayores de 3 años a que prohiban estas apps.

y aca en ARG estamos igual, lleno de pedofilos que ahora se muestran abiertamente a defender eso, diciendo que es algo natural que los chicos tienen que poder decidir si quieren ser culeados por un viejo de 60.

que es algo "natural"

-

años llevo diciendole a familiares y amigos que dejen de subir fotos publicamente de sus hijos y mismo yo ya ni subo fotos mias, todo lo mando por mensaje y grupos cercanos. hay mucha gente forra y los deepfakes se los comen 9 de cada 10 hoy por hoy

-

Que difícil legislar los límites de la tecnología... si un tipo es un enfermo pedófilo y para evitar cometer un delito aberrante genera porno de menores virtual, y no las comparte, hay realmente un delito?. Me lo pregunto, no tengo una respuesta definida. No se ha dañado a nadie, aunque no pasaría un comité de moral claramente.

-

Qué época de grises esta...

Lo que está claro es que si usaste esta aplicación y luego distribuís la foto, tenes una responsabilidad.