Un tema complicado nos legó el gran Asimov.

Creo, desde mi óptica pesimista, que naturalmente vendrán en modo egoísta.

Aunque, debo reconocer que la industria automovilística ha hecho algunas mejoras por el otro. Por ejemplo el peatón en caso de atropello, goza de un frente de impacto solidario. Lógicamente que esto es efectivo si se cumpliera la velocidad reglamentaria. Cosa que los autos robots cumplirán.

Es un tema difícil. Pero muy interesante

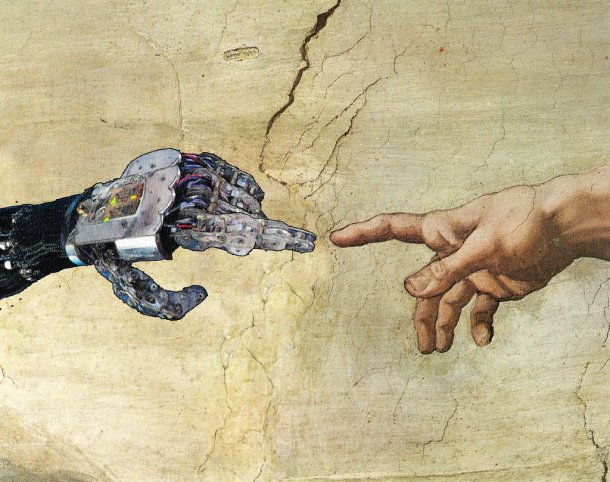

Autos Autónomos y cómo el orden robótico cambiará las leyes

Imaginen este escenario, tenemos un automóvil robot como los que Google está tratando de usar en el día a día, poco a poco logran que le aprueben el proyecto y en los próximos años serán la norma para manejarse en algunos lugares.

Autos que no cometen errores, cumplen con todas las normas de tránsito, no te meten la trompa, no te encierran, hacen todo como deben.

Pero he aquí que tenemos a un cerebro electrónico sin responsabilidad alguna tomando decisiones responsables pero ¿Y si sucede algo que requiera de una decisión terminal?

Tengamos en cuenta siempre las tres leyes de la Robótica de Asimov, la razón es simple, el viejo pensó en todo y las leyes son el resumen de años y años de novelas escritas para encontrarles la vuelta.

1.- Un robot no puede hacer daño a un ser humano o, por inacción, permitir que un ser humano sufra daño.

2.- Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la 1ª Ley.

3.- Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la 1ª o la 2ª Ley.

No hay máquina actual capaz de cumplir con estas tres leyes porque ninguna tiene conciencia de las palabras allí expresadas, es más bien cómo debería manejarse que cómo lo harán. Pero si basamos nuestros diseños en estas simples reglas empezamos a encontrarnos con los mismos problemas que Asimov expresó en sus novelas.

Asimov las pensó en 1942 cuando la idea era de Robots humanoides que compartirían la vida con nosotros, pero no pensó en robots que tuviesen cualquier otra forma mucho más pragmática.

Aquí es donde entran los automóviles autónomos, son robots, con forma de auto, no hay un valle de inquietante que nos moleste por su forma aunque es probable que a algunos piensen en Christine y deliren con la idea de un auto asesino.

No, el tema con los autos de este tipo es que tienen que tomar decisiones cuyas consecuencias van más allá de lo que pueden ver pero que un humano podría ver.

El caso típico es un accidente, imaginen que la programación del auto hará todo lo posible para evitarlo, es lógico, es la 1ª ley, es fácil de cumplir, o al menos intentarlo. Pero he aquí un poblema "asimoviano", que hará un auto de estos cuando su decisión condene a el conductor de su propio auto o a un ómnibus lleno de niños. La máquina debe elegir entre dos y por cómo se plantean las cosas en la actualidad los niños deberán aprender a nadar si caen desde ese puente sobre el río

¿La responsabilidad de quien será? La máquina ha decidido matar a aquellos niños, el bus escolar es ahora un cementerio sumergido, el auto decidió que era más importante proteger a sus pasajeros mas no al otro vehículo porque en su programación no existe más que evitar al tercero, no salvarlo.

Creo que es una de las partes más divertidas que le tocará a los legisladores del futuro ¿Quien cuernos es responsable? Ah! que dilema, el pasajero ya ni debería preocuparse por manejar, supongamos es el año 2050 y que ni sabe cómo conducir, ya nadie sabe, lo hacen las máquinas demasiado bien. Ante un accidente ¿Es responsable el fabricante? ¿El dueño? ¿El programador? ¿La máquina?

¿En qué punto es la máquina lo suficientemente compleja para ser "responsable" de una decisión? al fin y al cabo una computadora decide lo que le programamos que decida, cada opción que toma fue predefinida, si el autor del software no fue capaz de ver en su imaginación un escenario dado, no tendrá idea de cómo actuar.

No existe, todavía, ni la libertad de elegir ni de imaginar o crear una abstracción para suponer un resultado, sería genial, pero estamos en pañales al respecto, apenas estas máquinas tienen la capacidad de interpretar lo que las rodea a corta distancia.

Ayer Carlos (@Bad_Sky) me pasaba una nota sobre cómo los autos robóticos le van a hacer un hueco económico a las entidades que cobran multas

Con autos robóticos no necesitás ni de policías de tránsito!

Pero supongamos que el programa del auto puede analizar no sólo los objetos inmediatos sino predecir la trayectoria de estos y de muchos más a una mayor distancia ¿Debería optar éste por salvar a aquellos malditos niños y "asesinar" a su pasajero? ¿Quien decide la ética del software? ¿La moral puede ser programada? ¿Es ajustable por el dueño? ¿Aceptar o Cancelar?

Si nos diesen la posibilidad de configurar la sensibilidad moral de nuestro robot ¿Cómo la ajustarían? ¿Todo para mí, nada para él? ¿Se cagarían en todos?

Es intersante esto porque Asimov pensó que los robots vendrían con estos valores de fábrica pero yo temo que, al menos la primer generación robótica, nos dará esto configurable de forma egoísta.

Y es ese egoísmo el que deberá ser legislado, regulado, no la máquina en sí, la configuración moral de la misma.

Otros posts que podrían llegar a gustarte...

Comentarios

-

hola, buena reflexion, igual creo que si se llega a una semi utopia con esto de los autos robots, habria infimos accidentes, porque:

Los autos(como vos decis) sabran la ubicaciones del resto de los autos, por ende ninguno se cruzara ni nada.

La gente sera mas conciente de esto y no cruzaran la calle por cualquier lado. o sino cercar las calles, o poner sensores para que los autos sepan que a 300 metros por ejemplo hay un boludo cruzando.

Si esta mal programado el auto... se le actualizara el firmware a una version nueva con algun que otro parche jaja(obvio que al principio va a estar lleno de fallas)

Y lo de no saber manejar no creo, eso tendria que ser obligatorio, porque no va a estar el mundo 100% automatizado, y lugares como por ejemplo el campo, calles de tierra etc, uno tendra que manejar con sus propias manos.

-

Como usted dice Asimov pensó en todo, y pensó en robot con forma de autos SALLY http://estoespurocuento.wordpress.com/2013/11/10/isaac-asimov-sally-cuento/, creo que no tiene otro.

-

El problema mayor según veo esta en crear una dependencia al auto robot, de momento no creo que cuaje tanto, ya sea por costos y por que la gente todavía quiere seguir manejando su auto. Pero a medida que se vaya instaurando como algo normal y no sea necesario saber conducir un auto para subirse y que te lleve, podemos llegar a chocarnos con estas incidencias.

Para mi la solución es automatizar solo las funciones mas repetitivas, y dejar que las funciones donde el escenario típico pueda cambiar, como un viaje largo o un recorrido fuera del mapa, todavía sigan dependiendo de un humano.

La utilidad de esto, yo la veo como un control de crucero inteligente. Mientras no toques el acelerador, ni el volante, el auto se maneja solo, pero la prioridad siempre la tiene el conductor y su mando. En tal caso, escenarios donde el auto no necesite conductor, pueden ser, estacionar y avanzar hacia el dueño, cuando este lo llame. Pero mas de ahí no creo que sea necesario llevar la automatización.

Para un ejemplo clarisimo tenemos los motorman de los trenes de once. El sistema esta 90% automatizado, el conductor solo tiene que arrancar y frenar cuando sea necesario, en caso de accidente, pese a que los frenos pudieron haber fallado, toda la culpa cayo sobre el motorman por no accionarlos correctamente o a tiempo.

-

a ver, quien decia que hoy no es costeable hacer un auto automatico, aviso que es falso, hoy en dia tenemos la tecnologia necesaria para hacerlo, solo falta el bootstrap, es decir el despegue inicial .

Con ese despegue masivo el costo de la tecnologia cae por el piso y avanzaria muchisimo en un corto tiempo...

piensen lo que fue el primer iPhone o el primer celular con Android y vean lo que hacen los Android de hoy en dia (los iPhone se quedaron en los laureles)

El tema que plantea Fabio ya ha sido estudiado muchisimo y la idea predominante es la de usar ejemplos biologicos que hoy en dia existen: cardumenes o bien bandadas de aves.

en ambos tienes un grupo masivo de individuos que coordinan sus movimientos para evitar el caos o minimizarlo cuando este ocurre.

hay dos escuelas de pensamiento sobre como hacer el auto automatico.

1) totalmente independiente, es lo que esta haciendo google (y otros) hoy en dia, la idea es que el auto no depende de nada externo para llevar al pasajero del punto A al B.

me gusta este acercamiento dado que permitiria convivir autos autonomos con vehiculos (mal) manejados por seres (in)humanos.

2) existen demarcaciones electronicas de sendas, los vehiculos se intercomunican para avisar de acciones, etc.

esto seria mucho mejor, tipo las peliculas Quinto Elemento, Minority Report, I Robot y similares. donde los vehiculos les programas un destino, el mismo gestiona un lugar en el camino, los vehiculos se avisan en caso de accidente para frenar de emergencia, maniobras, etc.

igualmente este acercamiento requiere fuerte inversion de señalizacion, que todos los vehiculos sean automaticos, etc.

en mi opinion, el auto autonomo va a llegar en el momento en que los gobiernos los impulsen, y eso en yanquilandia no va a pasar con el lobby de las automotrices de alla.

-

Se le puede poner un factor random en caso de tener que tomar decisiones, no?

Por el tema de las multas, me parece muy bien que desaparezcan. Los entes que hacen y cobran las multas, tienen como objetivo castigar al infractor para que les duela haberse mandado una infracción, y no lo vuelvan a repetir (en teoría, ya sabemos que aca son un organismo recaudatorio). O sea, el objetivo de estos entes es dejar de existir...

-

Hmmm... para el caso del "dilema moral" (salvarme yo u el otro), no aplicaría independientemente de que el auto lo conduzca un humano? Y más allá de la cuestión "moral", ninguna ley obliga a autoinmolarse...

-

A mi me parece que el problema es la transición. Una vez que todos los autos sean robots y se comuniquen entre sí, las probabilidades de colisiones serán casi nulas. En la mayoría de los casos las causas de una colisión suelen ser dos: rotura del vehículo y/o exceso de velocidad. Un robot capaz de manejarse por el tránsito también deberá ser capaz de conocer su "salud". Si detecta una falla no solo avisa al conductor (hoy esto ya sucede) sino que se niega a transitar. El exceso de velocidad se evita porque el auto se adaptará a cada situación. Controlando esto solo quedan factores externos, a los que sí habrá que dotarlos de un árbol de decisión. Porque, a fin de cuentas, el problema será la programación.

Volviendo a mi primera frase, el problema será cuando empiecen a circular los autos robot y compartan calles y rutas con autos no-robot (o sea todos los actuales). Serán, como dijeron en comentarios anteriores, sistemas egoístas ya que deberán suponer que los otros autos no tienen "conciencia social". Pero tampoco serán robots con muchas facultades, las decisiones que tome serán las que le hayan programado. Más que firmware, imagino que deberán ser actualizaciones constantes como en Linux, evolucionando en un ciclo de "prueba y error" en la que habrán muertes y heridos pero aprendiendo de cada caso para ir dotando a los robots de cada vez más "inteligencia", o capacidad de adaptarse al tránsito. Después de un tiempo, y en la medida que los robots sepan resolver más situaciones y hayan cada vez más robots y menos no-robots, los conductores dejarán de ser necesarios y ahí sí, habremos llegado al futuro que imaginaron hace décadas.

-

Es el eterno dilema entre deontologismo y utilitarismo...

Si lo que gana es el utilitarismo, entonces será el día en el cual las máquinas gobernaran a los seres humanos, pero no en el sentido que nos imaginaron las películas...

Cada ser humano estará entrando en un auto sabiendo que el que maneja no dudará en matarlo para salvar a un micro con chicos, cuestión que hoy está reservada al libre albedrío de cada persona, hoy en día nadie va preso por tener que entregar su vida para salvar a otros, en cambio con una programación utilitarista sí, estaremo presos de una máquina que nos matará sin dudarlo. Porque no sabe dudar.

-

Como todos dicen, los accidentes solo van a existir en un escenario mixto. Pero cuando todos sean robots (y la gente no sea kamikaze) va a estar todo bien.

GET TO THE CHOPAH

-

Danbat dijo:

Más que firmware, imagino que deberán ser actualizaciones constantes como en Linux, evolucionando en un ciclo de "prueba y error"

Será una...

Rolling release.

Bueno, agregando a los puntos de Danbat y Gustavo V, me parece que una vez instalado un sistema, los errores van a ser manejados de la misma forma que ahora en la actividad aeronáutica, donde (alguien que sepa mas que me corrija) creo que ya no se habla de error humano sino de error del sistema; dicho sistema tiene que contemplar desde cuestiones mecánicas hasta el tiempo que se le deja al piloto para dormir entre vuelo y vuelo. Con los autos sería similar, en especial si van a operar intercambiando información entre ellos (lo que haría posible cosas como que tu auto decida chocar para que el resultado de todo el accidente sea menor, si hay varios vehículos mas involucrados).

Lo que sí va a ser muy gracioso, al menos en las primeras épocas, es no poder cruzar a Chile de vacaciones sin tocar el volante porque tu auto es región 4 y en Chile son todos región 5...

-

Matth dijo:

Solamente soy yo el que ve en el futuro mas bicis que autos-robots?

Si hay autos roboticos decidiendo si voy a vivir o morir, yo elijo la bici el "dos patas"

-

Curioso que nadie haya notado que la situación de decidir entre el pasajero y uno o mas pendejos es similar a lo que paso en Yo Robot (la película, no el libro).

Fabio, me parece que te estas adelantando unos cuantos siglos con lo de la moral en los robots, debidos a que:

-Una computadora, al igual que estos vehiculos autonomos, solo lleva determinada programación para hacer una o varias tareas. Su programación es automática y limitada a lo que el programador pueda indicarle, no tiene discernimiento propio, y menos aún pensamiento abstracto.

-Ese tipo de decisiones solo se pueden tomar teniendo libre albedrío y esa facultad solo pertenece a los seres encarnados con razonamiento abstracto (o sea, vos, yo y todos humanoides medianamente pensantes en este y otros mundos).

-Para que un robot pueda inferir este tipo de cosas, debería ser una forma de vida artificial que disponga de un decodificador (a lo que probablemente Asimov llamaría "cerebro positronico" lo suficientemente avanzado como para poder albergar un espíritu. O sea, algo mas cercano a Data o los Transformers que a un autómata per se.

lo suficientemente avanzado como para poder albergar un espíritu. O sea, algo mas cercano a Data o los Transformers que a un autómata per se.

En definitiva, si llegase a ocurrir el tipo de accidente que planteas, seria culpa del programador (a menos que el usuario del vehículo haya metido mano en la programación principal del sistema, en ese caso también seria su culpa por jugar al kaker y salirle el tiro por la culata). Lo mas responsable que pueden hacer los fabricantes es dejar un "modo manual" para que el usuario maneje el vehículo en caso de emergencia o cuando no sepa que hacer.

Sylar dijo:

Los autos(como vos decis) sabran la ubicaciones del resto de los autos, por ende ninguno se cruzara ni nada.

Esa es una posición muy simplista, ¿que pasa si alguien decide conservar el auto de toda la vida antes de conseguirse un auto robot? Seguramente habrá unos cuantos así por lo que en estos casos, ¿como hace el auto robot para predecir que va a hacer el auto normal y por ende evitar un accidente?

Danbat dijo:

Un robot capaz de manejarse por el tránsito también deberá ser capaz de conocer su "salud". Si detecta una falla no solo avisa al conductor (hoy esto ya sucede) sino que se niega a transitar.

Seamos honestos, si el auto no quiere moverse por un problema X o Y, no faltara el langa que intente hacerlo andar hackeando el firmware (ya sea por prisa o por que el arreglo cuesta un ojo de la cara), lo cual se convertiría en un riesgo potencial para los demás autos. Salvo por eso, seria el equivalente digital de hacer arrancar el auto sin llaves cruzando algunos cables.

-

En realidad la cuestion que plantea Fabio es otra, decidir entre la vida de dos seres humanos, cual es mas importante?, siempre se dice ante cualquier catastrofe "primero mujeres y niños" si nos regimos por esto sería mas importante la vida de un niño y no de quien va en el otro vehiculo, asi que ya tendriamos una respuesta, el auto robot matara a quien va de pasajero y no a los niños que van en el otro

-

Un ejemplo de lo que ya se hizo y como funciona salio en la tele en una serie, que era un concurso patrocinado por DARPA, donde universidades de eeuu tenian que hacer un auto autonomo. Tenian libertad para ponerle sensores y fierros (darpa es parte de la secretaria de defensa de eeuu) y tenian varios "desafios". El ultimo era un recorrido en una ciudad, con trafico de autos manejados por gente y los autos autonomos....y andaban ( esto tiene, al menos 6 o7 años).....tenian, los autos gps , sensores varios y una ruta, nada mas ( aparte de las normas de trafico) para andar por ahi....

Cuanto mas claras son las reglas, menor probabilidad de que se puedan interpretar de formas " creativas" para una maquina que tiene un algoritmo y no razona fuera de esa logica

-

La IA tendrá que evolucionar muchisímo antes que cualquier aparato pueda tomar una decisión de este tipo; creo que ninguno de los que está leyendo esto llegue a vivir para ver algo así y no sé si querría estar vivo para verlo: una máquina tomando decisión sobre la vida humana (aunque indirectamente hoy lo hacen: los sistemas de IA de las bolsas de valores hacen ricos o pobres a unos cuantos dependiendo del humor del mercado)

-

Yo lo pienso por otro lado... a ver... Suelo andar bastante en moto, habitualmente todos los días. Medio que mi cabeza puede "predecir" ciertas maniobras que hacen los autos, y trazar una ruta imaginaria entre ellos. No estoy hablando de andar haciendo slalom, sino, lo habitual.

Al mismo tiempo soy sysadmin y mi cabeza también desarrolló ese "sexto sentido" de predecir que va a hacer tal o cual aplicación, o como se comportará sin siquiera conocer el algoritmo que la rige, o una línea de su código.

Ahora bien, aplicando ambas cosas... medio que podés hacer DESASTRE lliteralmente... imagináte que podés predecir mas o menos como se va a comportar tal o cual auto cuando vos te le pongas adelante...

Los chorros... que le saltan a la gente que pasan cercanos a las villas... o sea. "me pongo acá y el auto frena"... Listo, robado... chau, a otra cosa...

-

Conociendo a las "entidades que viven de las multas" seguramente encontrarán la manera de multarte aunque el auto se maneje solo. Por ejemplo se me ocurre que te pongan multa por hacer que tu auto salga solo de tu casa a la oficina a buscarte el viernes a la tarde para salir para Mar del Plata. Auto que anda solo sin humano adentro: $1500 y 1 punto de scoring, rebajas por pago en término.

Supongo que la mayoría de las piñas van a ser entre rusos borrachos y Google cars. O argentos y brasileros pasando a 180 km/h la filita ordenada de autos automáticos a 100 km/h en la Ruta 23.

Y el futuro con todos andando en bambucletas al laburo que les queda a 5 cuadras del centro verde de cada barrio lo veo un poco utópico, vamos más camino al Quinto elemento.